Co to jest „Shape”?

To narzędzie umożliwia osobom niewidomym nawigację wyłącznie za pomocą dotyku, wykorzystując haptykę, czyli sygnały wyczuwalne dotykiem. Dzięki temu osoby niewidome mogły wykonać zadania lokalizacyjne z taką samą skutecznością, jak osoby widzące (badanie zrealizowano z wykorzystaniem wirtualnej rzeczywistości w pomieszczeniu).

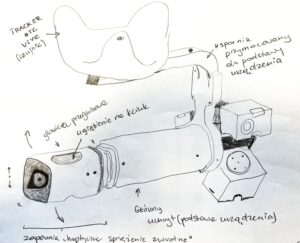

„Shape” wskazuje kierunek osobie z niepełnosprawnością wzroku poprzez zmianę swojego kształtu. Wyglądem przypomina latarkę: zgina się, gdy należy zmienić trasę, a prostuje, gdy użytkownik znajduje się na właściwej drodze (rysunek prototypu w dalszej części artykułu). To innowacyjne rozwiązanie pozwala osobom niewidomym szybko zrozumieć, jak się poruszać, bez potrzeby skupiania się na sygnałach dźwiękowych czy wibracyjnych.

Kto tego dokonał?

Zespół badaczy z Imperial College London, we współpracy z organizacją Bravo Victor i firmą MakeSense Technology, stworzył to innowacyjne urządzenie o nazwie „Shape”. W czasopiśmie Scientific Reports opublikowano badania dotyczące tego urządzenia, w których udział wzięło 10 osób z niepełnosprawnością wzroku oraz 10 osób widzących. Wyniki były obiecujące i pokazały, że osoby niewidome korzystające z „Shape” były w stanie lokalizować cele równie skutecznie jak osoby widzące. Firma odpowiedzialna za rozwój urządzenia planuje jego dalszą ewolucję, a pierwsza komercyjna wersja ma trafić na rynek pod koniec 2025 roku.

Dlaczego to jest potrzebne?

Nowy sposób nawigowania osób niewidomych jest potrzebny, ponieważ dotychczasowe metody dostarczania informacji, takie jak nawigacja głosowa czy bodźce wibracyjne, mimo swojej skuteczności w ostrzeganiu o zdarzeniach (np. powiadomienia na smartfonie), mogą stać się nieefektywne po dłuższym czasie (badanie1, badanie2, badanie3 ). Z czasem tego typu sygnały (wibracje) mogą powodować irytację i rozproszenie uwagi, a także prowadzić do odrętwienia, co sprawia, że użytkowanie takich urządzeń staje się mniej komfortowe (badanie4, badanie5). Te ograniczenia wskazują na potrzebę opracowania alternatywnego interfejsu, który byłby bardziej odpowiedni i komfortowy w przypadku cyfrowych urządzeń nawigacyjnych dla osób niewidomych. Takie rozwiązanie mogłoby się sprawdzić podczas nawigowania w mieście i szeroko pojętej turystce. Dłonie z natury sprawdzają się w postrzeganiu zmiany kształtu przy stosunkowo niskim obciążeniu poznawczym (badanie6), a naukowcy z Imperial College London, współpracujący z firmą MakeSense Technology, wykazali potencjał dotykowego interfejsu poprzez liczne badania różnych prototypów tego urządzenia (badanie7).

Jak to dokładnie działa?

Opisane doświadczenia i testy były przeprowadzone w „warunkach laboratoryjnych”, więc nie mają póki co przełożenia na rzeczywistość, w artykule czytamy:

„Do eksperymentu zrekrutowano uczestników widzących oraz z niepełnosprawnością wzroku, którzy mieli za zadanie zlokalizowanie serii 60 niewidocznych wirtualnych celów w przestrzeni 3D. W tym celu wykorzystali oni urządzenie „Shape” oraz urządzenie wibracyjne (Vibration) o 1 stopniu swobody, które reprezentowało standardowe technologie nawigacyjne dostępne obecnie na rynku. Uczestnicy widzący dodatkowo używali zestawu słuchawkowego rzeczywistości wirtualnej, aby zlokalizować cele za pomocą wzroku.

Zadanie polegało na skierowaniu urządzenia na wirtualny cel z dokładnością poniżej 7 stopni kąta zenitalnego i utrzymaniu tej orientacji przez dwie sekundy, po czym prezentowany był kolejny cel. Orientację i położenie urządzeń rejestrowano przy użyciu systemu lokalizacji HTC Vive. Uczestnicy nie nosili zestawu słuchawkowego ani opaski na oczy podczas używania urządzeń „Shape” i „Vibration”. [Tłumaczenie ChatGPT]. Źródło: https://doi.org/10.1038/s41598-024-79845-7

Zatem użyte technologie w badaniu to:

- tracker HTC Vive Pro – to czujnik wykorzystywany w systemach wirtualnej rzeczywistości (VR), który pozwala na precyzyjne śledzenie ruchów obiektów w przestrzeni 3D. Tracker HTC jest wykorzystywany między innymi do naukowych eksperymentów w środowisku 3D.

- zestaw słuchawkowy (VR Headset) – potocznie zwane goglami VR, to urządzenie montowane na głowie, które wykorzystuje wyświetlacze 3D blisko oczu i śledzenie położenia, aby zapewnić użytkownikowi środowisko rzeczywistości wirtualnej – cele były identyfikowane w rzeczywistości wirtualnej

- „interfejs dotykowy” czyli właśnie urządzenie „Shape” przypominające latarkę z ruchomą głowica przegubową.

- urządzenie wibracyjne (Vibration) – w domyśle wykorzystanie wibroaktywnego sprzężenia zwrotnego (?)

Jakie są ograniczenia dla tego urządzenia?

Potrzebne są dalsze badania, aby zrozumieć, jak urządzenie Shape sprawdza się w bardziej zmiennych scenariuszach rzeczywistych. Nie jest to pierwszy prototyp tego urządzenia, tak wynika z informacji zawartych z artykułu na ten temat, poza tym badania które tu też przytaczam (testy na 10 osobach niewidomych) były wykonywane w kontrolowanej sytuacji w pomieszczeniu z wirtualnymi celami.

Ostatecznie, aby Shape mógłby być kompleksowym urządzeniem nawigacyjnym musiałby być zintegrowany z systemem nawigacyjnym lub komputerowym (?) oraz musiałby przejść testy w sytuacjach zmiennych i warunkach zewnętrznych (rzeczywistych), np. podczas pieszych wycieczek lub nawigacji po mieście.

Można powiedzieć że „Shape” jest trendem w technologii wspierającej, a nawet trendem w turystyce dostępnej. Mógłby być produktem uniwersalnym skierowanym do każdego, w tym osób z niepełnosprawnościami, segmentowanie wynika pewnie z innych powodów. Jak można podsumować to jednym zdaniem? „Od czegoś trzeba zacząć”.

Dlaczego mimo wszystko to jest ważne?

Jest nadzieja, że to urządzenie, uważane za najbardziej zaawansowane w swoim rodzaju, może stać się przyszłością technologii nawigacyjnej dla osób niewidomych i słabowidzących, ponieważ Shape ma wiele zalet w porównaniu z obecnymi narzędziami służącymi do nawigowania.

Przy założeniu, że uda się go zintegrować z technologią np. TOTUPOINT, NFC czy czymkolwiek podobnym (kamerą, która identyfikuje lokalizację obiektów lub znaczników umieszczonych w naszym otoczeniu), mógłby zapewnić większą precyzję i wygodę niż tradycyjne technologie, takie jak sygnały wibracyjne (np. kołnierze wibracyjne itd.). Zastosowanie w turystyce byłoby przełomowe! Ale… do tego czasu może upłynąć jeszcze wiele lat, dlatego stawiam „Shape” na półce razem z wirtualną postacią ludzką do translacji wypowiedzi na PJM w czasie rzeczywistym 🙂 Będę się przyglądać rozwojowi tych technologii.

Autorka: Aneta Bilnicka

Rysunek własny na podstawie prototypu: https://www.nature.com/articles/s41598-024-79845-7/figures/1

Zdjęcie poglądowe: Pexels

Cytowanie: Bilnicka, A. (2024, 17 grudnia). Testy urządzenia „Shape” do nawigacji dotykowej. Turystykadostepna.pl https://turystykadostepna.pl/2024/12/testy-urzadzenia-shape-do-nawigacji-dotykowej/

Literatura:

- A. J. Spiers and A. M. Dollar, Outdoor pedestrian navigation assistance with a shape-changing haptic interface and comparison with a vibrotactile device. In: 2016 IEEE Haptics Symposium (HAPTICS), 34–40, https://doi.org/10.1109/HAPTICS.2016.7463152 (2016).

- D. Dobbelstein, P. Henzler, and E. Rukzio, Unconstrained pedestrian navigation based on vibro-tactile feedback around the wristband of a smartwatch. Presented at the Proceedings of the 2016 CHI Conference Extended Abstracts on Human Factors in Computing Systems (2016).

- J. V. S. Luces, K. Ishida, and Y. Hirata, „Human position guidance using vibrotactile feedback stimulation based on phantom-sensation. In: 2019 IEEE International Conference on Cyborg and Bionic Systems (CBS), 235–240, https://doi.org/10.1109/CBS46900.2019.9114479 (2019).

- M. Aggravi, S. Scheggi, and D. Prattichizzo, Evaluation of a predictive approach in steering the human locomotion via haptic feedback. In: 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 597–602, https://doi.org/10.1109/IROS.2015.7353433. (2015).

- Quinn, R., Murtough, S., de Winton, H. et al. A shape-changing haptic navigation interface for vision impairment. Sci Rep 14, 29223 (2024). https://doi.org/10.1038/s41598-024-79845-7

- Spiers, AJ i in. Testowanie urządzenia nawigacyjnego dotykowego zmieniającego kształt z udziałem widzów z wadami wzroku i widzących w immersyjnym otoczeniu teatralnym. IEEE Trans. Hum. Mach. Syst. 48 (6), 614–625. https://doi.org/10.1109/THMS.2018.2868466 (2018).

- Z. Liao, J. Salazar, and Y. Hirata, Robotic guidance system for visually impaired users running outdoors using haptic feedback. In: 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 8325–8331, https://doi.org/10.1109/IROS51168.2021.9636567 (2021).

Jeśli podobał Ci się ten artykuł i chcesz wesprzeć moją pracę, rozważ kliknięcie przycisku poniżej: POSTAW MI KAWĘ Zrób to tylko wtedy, gdy możesz sobie na to pozwolić finansowo, ponieważ są to trudne czasy dla nas wszystkich – Dziękuję!